La seguridad psicológica, el “acelerador” cultural que decide si la IA escala

Informe "Creating psychological safety in the AI era", de MIT Technology Review Insights en colaboración con Infosys Topaz_

Confiar en la IA empieza cuando los líderes admiten lo que no saben, abordan los miedos y ayudan a las personas a adaptarse. Esa frase, al inicio del informe Creating psychological safety in the AI era, resume el argumento central del estudio: la adopción de IA en la empresa no depende solo de modelos, datos e infraestructuras, sino de algo más frágil y determinante: la disposición humana a experimentar, discrepar, señalar fallos y aprender en público.

El informe, elaborado por MIT Technology Review Insights en colaboración con Infosys Topaz, se apoya en una encuesta a 500 ejecutivos y directivos senior globales realizada entre junio y julio de 2025, además de entrevistas con expertos en desarrollo organizativo, psicología del trabajo y evolución de la IA.

Desafío técnico y humano

Desplegar IA a escala equivale a escalar dos paredes al mismo tiempo. La primera, entender e implementar la tecnología. La segunda, construir las condiciones culturales para que las personas maximicen su valor. Y aunque el reto técnico es considerable, el informe advierte que el factor humano puede ser todavía más decisivo: el miedo y la ambigüedad pueden frenar incluso iniciativas prometedoras.

En ese marco, la seguridad psicológica —definida como un entorno en el que la gente se siente segura para asumir riesgos, expresar ideas, admitir errores y hacer preguntas sin temor a daño profesional— pasa de “bienestar” a capacidad empresarial. De hecho, el informe lo describe como un elemento esencial para introducir una tecnología poderosa, aún sin mejores prácticas plenamente establecidas, y que exige iteración continua.

83% ve impacto medible en el éxito de la IA

Los datos del estudio son explícitos: el 83% de los encuestados considera que la seguridad psicológica tiene un impacto medible en el éxito de las iniciativas de IA. Dentro de ese grupo, el 49% afirma que contribuye directamente (mejor colaboración, mayor toma de riesgos, resultados de innovación) y el 34% que lo hace de forma indirecta pero relevante.

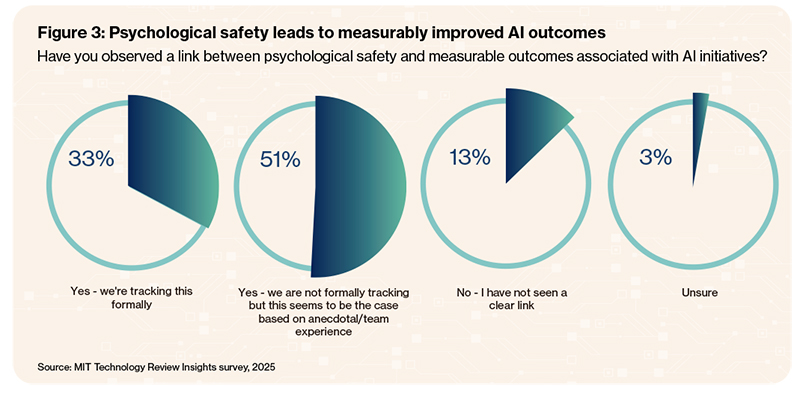

El argumento no se queda en la percepción: el 80% está de acuerdo en que las organizaciones que fomentan seguridad psicológica son más exitosas adoptando IA (49% “muy de acuerdo” y 31% “algo de acuerdo”). Además, el 84% declara haber observado una relación entre seguridad psicológica y resultados medibles asociados a iniciativas de IA; en concreto, un 33% dice que lo está midiendo formalmente, mientras que un 51% lo observa sin medición formal (por experiencia o evidencia anecdótica).

Vínculo con outcomes medibles (tracking formal vs. informal): El 84% observa una relación entre seguridad psicológica y resultados medibles de IA; un 33% la está midiendo formalmente. / Fuente: encuesta MIT Technology Review Insights, 2025.

El 75% de las organizaciones que han llevado a producción la mayoría de sus proyectos de IA en los últimos 12 meses afirma que su cultura “fomenta fuertemente” la experimentación

Un dato especialmente útil para la agenda de “scale-up” es el vínculo entre cultura experimental y paso a producción. Entre las organizaciones más exitosas —aquellas que han llevado a producción entre el 76% y el 100% de sus proyectos de IA en los últimos 12 meses— el 75% afirma que su cultura “fomenta fuertemente” la experimentación. En el extremo opuesto, en empresas donde ningún proyecto avanzó a producción, el 47% describe su cultura como neutral respecto a experimentar con IA.

Por qué el miedo sigue frenando

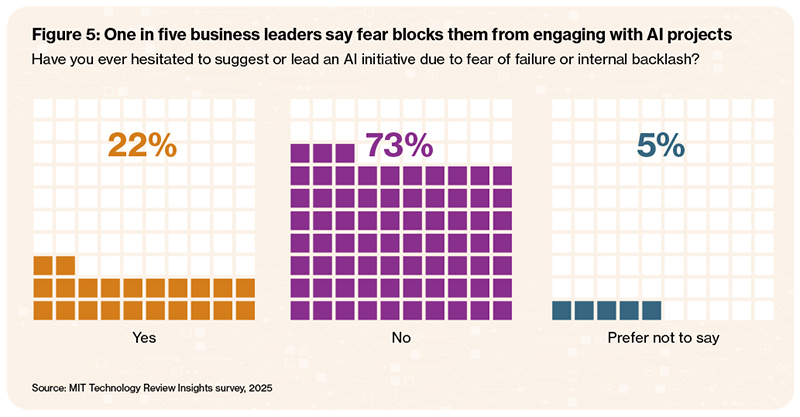

La investigación muestra una tensión significativa entre la retórica y el comportamiento real. Por un lado, casi tres cuartas partes (73%) dicen sentirse seguras para dar feedback honesto y expresar opiniones libremente. Por otro, un 22% admite haber dudado en sugerir o liderar iniciativas de IA por miedo a fallar o por temor a reacción interna (y un 5% prefirió no responder).

Miedo como freno al liderazgo de IA (22%): Uno de cada cinco líderes reconoce haber evitado proponer o liderar iniciativas de IA por temor al fracaso o a la reacción interna. / Fuente: encuesta MIT Technology Review Insights, 2025.

La evaluación más detallada de seguridad psicológica también revela matices: solo el 39% la califica como “muy alta” (se sienten consistentemente seguros para expresar ideas, admitir errores o asumir riesgos sin consecuencias negativas), mientras que un 48% la sitúa en un nivel “moderado” (generalmente se sienten seguros, pero se autocensuran según el contexto o la audiencia). Un 9% declara niveles bajos o muy bajos, y un 3% no contesta.

En conclusión, parte de las organizaciones están tratando de acelerar la IA sobre una base cultural todavía inestable, lo que aumenta el riesgo de que el despliegue se quede en pilotos, se ralentice por silencios o derive en usos no alineados.

Acelerar la IA sobre una base cultural todavía inestable aumenta el riesgo de que el despliegue se quede en pilotos, se ralentice por silencios o derive en usos no alineados

En el escenario actual, el ritmo de cambio obliga a los equipos a adaptarse con información incompleta. Esa agilidad solo aparece cuando las personas pueden proponer ideas no convencionales o expresar dudas sin ser etiquetadas como resistentes. Esto explica por qué la seguridad psicológica se vuelve crítica. En entrevistas incluidas, se apunta además a una presión “insidiosa” en empresas que han invertido mucho: cuando hay expectativas de retorno, algunos empleados pueden evitar decir que algo “no está funcionando como se esperaba” por no contradecir la visión del CIO o la narrativa del liderazgo.

El actual ritmo de cambio obliga a los equipos a adaptarse con información incompleta. Esa agilidad solo aparece cuando las personas pueden proponer ideas no convencionales o expresar dudas sin ser etiquetadas como resistentes

A esto se suma una realidad práctica: desplegar IA a escala requiere pruebas continuas, ajuste de modelos, rediseño de flujos y detección de riesgos operativos o éticos en tiempo real. Si la cultura penaliza el error o el disenso, lo que se obtiene no es “adopción”, sino conformidad superficial.

Otras barreras

Cuando se pregunta por barreras observadas que impiden a “los pares” abrazar la IA en su rol, emerge otra lista:

- Falta de claridad sobre el valor (60%).

- Falta de formación (55%).

- Miedo a pérdida de empleo (40%).

- Miedo al fracaso (39%).

- Resistencia cultural (33%).

En preocupaciones personales, los líderes señalan sobre todo habilidades y formación (34%) y las implicaciones éticas (28%), seguidas por desplazamiento laboral (16)%. Solo un 12% afirma no tener grandes preocupaciones. Este matiz es importante: el miedo al fracaso no es el único freno, pero es lo bastante relevante como para desincentivar que alguien levante la mano y lidere un caso de uso. En IA, esa inhibición tiene coste: menos propuestas, menos aprendizaje, menos iteración y, por tanto, menos probabilidades de pasar de piloto a producción.

“Experimenta”… pero atente al coste reputacional del error

El informe de MIT apunta a un patrón típico: muchas empresas comunican que experimentar es seguro, pero en la práctica la señal cultural es “asume riesgos… siempre que sean los correctos y funcionen”. En ese entorno, los fallos no se castigan formalmente, pero sí pueden ser reputacionalmente caros, porque los proyectos visibles, promociones y oportunidades de liderazgo tienden a ir a perfiles con historial de victorias. Con IA —novedad, stakes altos, valor aún en definición— ese efecto se amplifica.

Además, el documento introduce otro riesgo colateral: si no hay refuerzo cultural y canales claros, algunos empleados pueden “volver silenciosamente” a formas antiguas de trabajo o, peor, experimentar con IA fuera de los circuitos aprobados, con riesgos de seguridad, ética o cumplimiento.

Empleo y liderazgo: dos aliados para construir seguridad psicológica

Cuando se pregunta qué ayudaría más a construir seguridad psicológica durante la adopción de IA, dos factores destacan por encima del resto:

-

60%: comunicación clara y transparente sobre cómo la IA afectará —y no afectará— a los empleos.

- 51%: liderazgo que modele apertura a preguntas, disenso o fracaso.

Después aparecen: sistemas de recompensa que celebren experimentación y aprendizaje (41%), colaboración cross-funcional (40%), formación estructurada en herramientas y uso responsable (35%), coaching externo (31%) y guardarraíles contra mal uso (incluido sobre-monitoreo) (29%).

Si no se habla bien del empleo, la ansiedad ocupa el espacio; y si el liderazgo no modela la apertura, el resto de iniciativas (formación, gobernanza, pilotos) pierden tracción

El mensaje es nítido: si no se habla bien del empleo, la ansiedad ocupa el espacio; y si el liderazgo no modela la apertura, el resto de iniciativas (formación, gobernanza, pilotos) pierden tracción.

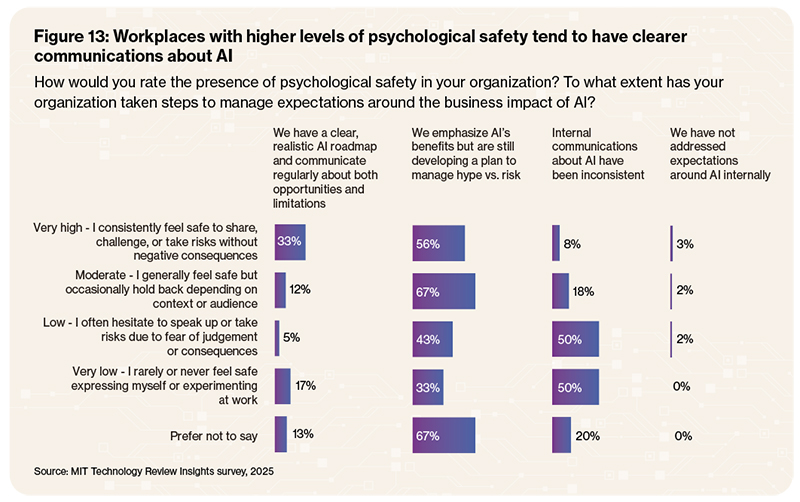

Por eso, la comunicación se convierte en "el músculo" esencial. Sin mensajes explícitos sobre las capacidades realistas, los límites y los casos de uso aprobados, la gente tiende a rellenar huecos con escenarios de riesgo. El propio estudio cuantifica el nivel de madurez: solo el 20% afirma tener un roadmap de IA claro y realista, con comunicación regular sobre oportunidades y limitaciones. La mayoría (60%) dice que su organización enfatiza beneficios, pero aún está desarrollando un plan para gestionar “hype vs. riesgo”; 17% habla de comunicaciones internas inconsistentes; 3% no ha abordado las expectativas.

Cruce seguridad psicológica vs. gestión de expectativas de IA: Las organizaciones con mayor seguridad psicológica declaran comunicaciones más claras y realistas sobre oportunidades, límites y riesgos de la IA. / Fuente: encuesta MIT Technology Review Insights, 2025.

Solo 1 de cada 5 tiene un roadmap realista bien comunicado. El informe demuestra que donde la seguridad psicológica es más alta, suele haber mejor gestión de expectativas y mejor comunicación sobre IA

Además, el informe muestra que donde la seguridad psicológica es más alta, suele haber mejor gestión de expectativas y mejor comunicación sobre IA (relación mostrada en figura cruzada).

HR + IT: la alianza que habilita el cambio

Un punto práctico destacable es la convergencia entre RR. HH. y Tecnología en la comunicación sostenida sobre IA. El estudio describe beneficios de equipos combinados para integrar IA en operaciones —una tarea que exige destreza técnica y gestión del cambio— y para “entrenar” a líderes en cómo comunicar y cómo establecer guardarraíles.

El documento incluye también una advertencia: tratar la IA como un proyecto puramente de IT suele conducir a adopción superficial y resistencia más profunda; el cambio es estratégico y cultural.

Otra conclusión relevante para empresas con ambición de escala: en organizaciones con más éxito moviendo IA de piloto a producción, es más probable que se observe y se mida el vínculo con seguridad psicológica. En el grupo de mayor éxito (76–100% de proyectos avanzados), casi dos tercios (63%) afirma que su organización rastrea formalmente esa conexión, y otro cuarto la reconoce informalmente. En niveles bajos de avance (menos de un cuarto), el tracking formal cae a 13% o menos.

En otras palabras, si quieres escalar IA de forma repetible, no basta con KPI técnicos (precisión, uptime, velocidad). Hay que incorporar señales humanas y de adopción: utilidad percibida, confianza, disposición a reportar fallos, calidad del feedback. Si quieres escalar IA de forma repetible, no basta con KPI técnicos, hay que incorporar señales humanas y de adopción: utilidad percibida, confianza, disposición a reportar fallos, calidad del feedback

Conclusión: nueve prácticas para pasar de “ideal” a “realidad”

El informe "Creating psychological safety in the AI era" propone algunas mejores prácticas bajo una idea latente para dirección: la IA ya no se decide solo en arquitectura o en presupuesto. Se decide, cada día, en si alguien se atreve a decir “esto no funciona”, “no lo entiendo”, “podemos probar otra cosa”, “creo que aquí hay un riesgo”. Donde esa conversación está permitida —y protegida— la probabilidad de escalar IA aumenta. Estos aprendizajes pueden ayudar a motivarla:

- La IA no es monopolio del líder: reconocer que el conocimiento puede fluir en múltiples direcciones; los líderes deben aprender también del equipo.

- Abordar pronto el temor al desplazamiento laboral, siendo explícitos sobre qué cambia y qué permanece.

- Gestionar el “future shock” (la velocidad de cambio puede superar la capacidad de procesarlo).

- Crear espacios seguros y “lúdicos” para probar, quitando dramatismo al aprendizaje inicial.

- Complementarlo con sandboxes formales, con guardarraíles, presupuesto y entorno dedicado.

- Recompensar el aprendizaje, no solo el resultado (valorar disposición a aprender por encima de ejecución perfecta).

- Activar el aprendizaje entre pares (“evangelistas” internos de IA, demos, lecciones aprendidas).

- Construir feedback loops efectivos, combinando herramientas formales con espacios informales seguros.

- Mirar el sistema completo: tecnología y resiliencia cultural deben desarrollarse en paralelo; la seguridad psicológica conecta el roadmap con los comportamientos diarios.

Contenido relacionado:

"La IA y la Organización Pulpo", de Jonathan Brill y Stephen Wunker.

Informe "Creating psychological safety in the AI era", de MIT Technology Review Insights en colaboración con Infosys Topaz.

Publicado en enero de 2026.

Últimos artículos