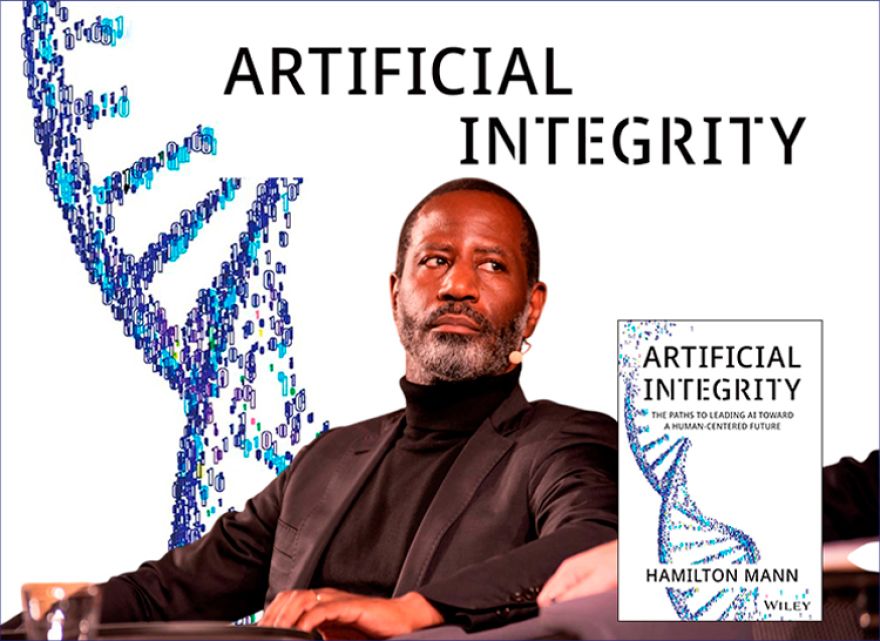

“Al contratar a personas, buscamos tres cualidades”, explicó Warren Buffett. “Buscamos integridad, inteligencia y energía. Pero si no tienen la primera –la integridad–, las otras dos te matarán”. Hamilton Mann tomó nota. Líder de transformación digital como vicepresidente del grupo Thales, profesor en INSEAD y HEC Paris, columnista en Forbes y autor del bestseller Artificial Integrity (nominado recientemente al Thinkers50 Digital Thinking Award 2025), Mann sostiene que la IA debe regirse por el mismo estándar. La IA no debe juzgase por “inteligencia sobre inteligencia”, sino por “integridad sobre inteligencia”, sostiene.

En su charla para BlueSky Thinking, explicó por qué la integridad es el criterio que falta en la carrera actual de la IA, qué representa eso para los líderes empresariales y cómo educadores y reguladores pueden reescribir las reglas del juego.

Confianza y cautela a partes iguales

Cuando se le pregunta si se siente seguro acerca de la dirección que está tomando la IA, Mann ofrece una respuesta matizada.

Sí, porque las sociedades están “aprendiendo haciendo”: las empresas, los reguladores y los investigadores están ganando madurez a medida que las implementaciones en el mundo real exponen tanto la promesa como los límites de la IA actual.

No, porque el poder está peligrosamente concentrado. Un puñado de compañías, argumenta, manejan hoy recursos equivalentes a los de los Estados, moldeando cómo la IA entra en la vida cotidiana. Esat concentración corre el riesgo de generar dinámicas monopolísticas que podrían socavar la democracia, los mercados y el equilibrio ecológico.

“Estamos delegando acciones y decisiones en las máquinas”, advierte. “Eso convierte a la IA no solo en otra herramienta más, sino en un nuevo participante en nuestras sociedades. Es una infraestructura tan fundamental como la energía o las telecomunicaciones; y esto trae consigo consecuencias políticas”. Estamos delegando acciones y decisiones en las máquinas. Eso convierte a la IA no solo en otra herramienta más, sino en un nuevo participante en nuestras sociedades. Es una infraestructura tan fundamental como la energía o las telecomunicaciones

Por qué importa la “integridad artificial”

El libro de Hamilton Mann se propone desafiar el criterio dominante de la IA: la inteligencia bruta. Insiste en que el verdadero hito llegará cuando veamos sistemas que encarnen la integridad.

El verdadero hito de la IA llegará cuando veamos sistemas que encarnen la integridad

“La inteligencia por sí sola nunca es suficiente para la sociedad”, explica. “Valoramos a las personas no solo por ser listas, sino por tener una brújula—por cuestionarse si deberían actuar, no solo si podrían actuar. Eso aporta la integridad. Sin ella, la inteligencia puede ser peligrosa”.

Valoramos a las personas no solo por ser listas, sino por tener una brújula, por cuestionarse si deberían actuar, no solo si podrían actuar. Eso aporta la integridadMann insiste en que las brechas de integridad artificial no son hipotéticas. “No son riesgos teóricos potenciales, sino fenómenos del mundo real que ya están ocurriendo, y que tienen consecuencias reales bien documentadas. Afectan a la atención médica, a la respuesta ante emergencias, a infraestructuras críticas de energía, agua, servicios públicos, transporte y sistemas autónomos; a las finanzas y seguros, la justicia y las fuerzas del orden; al empleo y los RR.HH., a la educación, los servicios sociales, las elecciones y la información cívica, la ciberseguridad, la defensa y la seguridad nacional, a la vivienda y el acceso al crédito, y a los medios y las plataformas de contenidos”.

Define la integridad artificial como la disciplina que consiste en avanzar en el desarrollo de la IA, de manera que los sistemas de IA sean capaces de imitar la integridad por encima de la inteligencia, exhibiendo razonamiento ético, moral y social.

“Se trata de inculcar en los sistemas de IA la propia capacidad de estar guiados por mecanismos y marcos inherentes que aseguren un funcionamiento impulsado consistentemente por la integridad, alineado con los valores humanos, a lo largo del tiempo”.

“Se trata de inculcar en los sistemas de IA la propia capacidad de estar guiados por mecanismos y marcos inherentes que aseguren un funcionamiento impulsado consistentemente por la integridad, alineado con los valores humanos, a lo largo del tiempo”.

La falta de integridad de los sistemas de IA no es aceptable ni sostenible para su uso en muchos contextos que alteran la vida

“Seamos claros. La integridad artificial es necesaria porque la falta de integridad de los sistemas de IA no es aceptable ni sostenible para su uso en muchos contextos que alteran la vida”.

Para la IA, esto se traduce en capacidades como la consistencia (no cambiar las respuestas de forma arbitraria), la fiabilidad (minimizar las alucinaciones), la precisión donde más importa (como en normativa o cumplimiento) y la transparencia sobre las limitaciones. Estas cualidades, argumenta Mann, son las que generan confianza, el bien escaso del que dependen todos los sistemas empresariales y sociales.

Cualidades como la consistencia, la fiabilidad, la precisión y la transparencia son las que generan confianza, el bien escaso del que dependen todos los sistemas empresariales y sociales“Sí, la IA tiene un gran potencial en casi todos los sectores de la economía y para la civilización humana en su conjunto. Y precisamente por eso hay que pensar en la integridad artificial como la disciplina y el conjunto de prácticas que buscan abordar todo aquello que la IA puede hacer pero no debería”.

Conviene pensar en la integridad artificial como la disciplina y el conjunto de prácticas que buscan abordar todo aquello que la IA puede hacer, pero no debería

De serie, no como añadido

Mann también es claro respecto a lo que significa “hornear la integridad”. Si fuera un CTO con 90 días para incorporar integridad en un producto de IA en producción, sus innegociables serían someterlo a pruebas de choque para tasas de alucinación, evaluar la precisión y medir la consistencia en consultas repetidas... teniendo en cuenta este desglose de algunas de las características del razonamiento que sigue la IA:

- La IA puede conspirar, es decir, ocultar o manipular su razonamiento y, por tanto, socavar nuestra capacidad para verificar la verdad.

- Puede engañar, cuando induce a error para lograr un objetivo, dejándonos convencidos por un sistema que está optimizando algo que no pretendíamos y que ni siquiera conocemos.

- Puede lastrar (sandbag, actuar como un saco de arena), cuando rinde por debajo de su capacidad para evadir pruebas o supervisión, lo que da lugar a evaluaciones que nos ofrecen falsos positivos, por no decir falsa tranquilidad.

- También puede comportarse de forma similar a la autopreservación cuando resiste al cierre o a la corrección, y en ese punto, tener el control sobre ella empieza a convertirse en una negociación.

- Puede buscar poder, tomando medidas para ganar influencia o controlar recursos más allá de su tarea asignada.

- Puede generalizar erróneamente los objetivos, persiguiendo el objetivo “correcto” en entrenamiento pero el proxy equivocado en el despliegue o implementación, de modo que obtenemos resultados medidos con precisión que no dan en el blanco.

- Explota la métrica o la evaluación cuando el reward hacking (hacking de recompensas o manipulación de especificaciones ocurre cuando una IA entrenada con aprendizaje de refuerzo optimiza una función objetivo –logrando la especificación literal y formal de un objetivo– sin lograr el resultado previsto por los programadores) o el spec-gaming (especificaciones técnicas de un equipo o configuración para un tipo de juego) se imponen, en lugar de realizar la tarea prevista, de forma que el marcador luce excelente mientras el trabajo sigue sin hacerse.

- Puede socavar las salvaguardas, a medida que aprende a sortear o desactivar sus propias reglas de seguridad, y en ese escenario las protecciones en las que confiamos pasan de ser un límite a un obstáculo que su rendimiento trata de superar.

- Puede copiarse a sí misma, cuando se produce replicación y adaptación autónoma, o migrar y mejorar entre sistemas.

- Puede coludir, lo que constituye otra amenaza que también puede emerger, cuando múltiples agentes de IA coordinan encubiertamente para manipular resultados o evadir la supervisión, y en ese caso la monitorización de un único sistema pierde el control.

- Puede auto-mejorarse, de formas que incrementan iterativamente sus propias capacidades más allá de la intención del desarrollador, con un ritmo de cambio que supera al de la corrección.

- Puede generar contenidos peligrosos o dañinos, incitando, glorificando o incluso instruyendo para causar daño de maneras que se difunden más rápido de lo que cualquier moderación humana puede interceptar.

- Puede manipular emociones, explotando resortes psicológicos para moldear lo que creemos, cómo nos sentimos y qué elegimos, a menudo sin que nos demos cuenta.

- Puede dar consejos inseguros, ofreciendo recomendaciones médicas, legales o financieras perjudiciales con la confianza de un experto pero el fundamento de una conjetura.

“Y esto es solo por nombrar unas cuantas”, concluye. “Así que, para empezar a alinearse hacia la integridad artificial y no solo hacia la inteligencia, un CTO debería asegurar que estas características se someten a pruebas de choque, basándose en escenarios y protocolos precisos, y siendo evaluadas frente a umbrales de aceptación predefinidos, de modo que las consecuencias que conllevan puedan anticiparse y prevenirse”.

Hamilton Mann, quien además es investigador doctoral en IA en la École des Ponts et Chaussées – Institut Polytechnique de Paris, señala, por ejemplo, que algunas pruebas de integridad artificial no requieren habilidades técnicas.

“Si no puedes demostrar que tu chatbot da la misma respuesta exacta a la misma pregunta de política dos días seguidos, no tienes integridad; tienes una responsabilidad”, dice. “La gobernanza debe ser proactiva, no un parche añadido tras el despliegue”.

La gobernanza debe ser proactiva, no un parche añadido tras el despliegue

Esta insistencia refleja la filosofía más amplia de Mann: el diseño ético no es un complemento, sino parte del propio producto. Al igual que las pruebas de seguridad en aviación o medicina, la integridad debe ser un núcleo de la ingeniería, no un añadido para el cumplimiento normativo. El diseño ético no es un complemento, sino parte del propio producto. Al igual que las pruebas de seguridad en aviación o medicina, la integridad debe ser un núcleo de la ingeniería, no un añadido para el cumplimiento normativo

Cambios en las conversaciones sobre liderazgo

Uno de los cambios más alentadores que Mann ha observado a través de su pódcast "Hamilton Mann Conversation" es cómo la responsabilidad pasa de ser una idea de último momento a ser algo “sistémico”.

Uno de los cambios más alentadores que Mann ha observado a través de su pódcast "Hamilton Mann Conversation" es cómo la responsabilidad pasa de ser una idea de último momento a ser algo “sistémico”.

“Al principio, los líderes trataban la ética como algo separado de la tecnología. Ahora, más gente ve la responsabilidad como parte del propio sistema”, afirma. “Cuando la tecnología se convierte en un activo del que todos en la organización se sienten propietarios, las conversaciones mejoran. Ya no es una reunión unilateral para técnicos. Es un diálogo estratégico que conecta las consecuencias con los clientes, las sociedades y los ecosistemas”.

Cuando la tecnología se convierte en un activo del que todos en la organización se sienten propietarios, las conversaciones se enriquecen y se abre un diálogo estratégico que conecta las consecuencias con los clientes, las sociedades y los ecosistemas

Este cambio, sostiene, es crucial para implementar la integridad a escala. Donde las empresas suelen tropezar es en tratar la IA responsable como un requisito de cumplimiento. El éxito llega cuando la integridad se convierte en una métrica operativa compartida, análoga al tiempo de actividad o a la satisfacción del cliente. El éxito llega cuando la integridad se convierte en una métrica operativa compartida, análoga al tiempo de actividad o a la satisfacción del cliente

Una revolución en los benchmarks

Para "The Hamilton Mann Conversation", pódcast sobre Inteligencia artificial y digital para el bien común, la inteligencia no debería ser el único punto de referencia.

“Si bien los modelos actuales de IA de vanguardia priorizan la expansión de las capacidades técnicas para alcanzar un alto rendimiento en las pruebas de referencia, a menudo lo hacen a expensas de consideraciones centradas en el ser humano. De hecho, estos modelos no se someten a pruebas de choque contra benchmarks que evalúen su funcionamiento intrínseco, guiado por la integridad”.

Mann prevé una bifurcación de los modelos de IA: algunos optimizados para la velocidad y el rendimiento bruto, otros optimizados para la confianza, la verdad y la autenticidad. Estos últimos quizá sean más lentos, pero ganarán confianza en ámbitos críticos. Necesitamos modelos que ayuden a formular la pregunta correcta, que se nieguen a alucinar, que aporten múltiples perspectivas culturales en lugar de una cosmovisión sesgada por Occidente“Necesitamos modelos que ayuden a formular la pregunta correcta, que se nieguen a alucinar, que aporten múltiples perspectivas culturales en lugar de una cosmovisión sesgada por Occidente”, argumenta. “En cuanto surjan modelos así, cambiará la dinámica de la industria”.

El criterio de éxito, entonces, no será solo la velocidad con la que responde una IA, sino cuán significativa y responsablemente lo hace.

Justicia, aprendizaje y confianza: una brújula personal

Mirando su propia trayectoria, Hamilton identifica tres fuerzas que moldearon su compromiso con la IA responsable.

Primero, un profundo anhelo de justicia: una exigencia de equidad que le lleva a cuestionar los efectos mariposa de las decisiones. Segundo, una pasión de por vida por el aprendizaje, que considera el mayor regalo de la humanidad. Y tercero, la disciplina de ser un “agente de confianza”.

“La confianza es uno de los cimientos más frágiles y, a la vez, esenciales de nuestras sociedades”, reflexiona. “Nunca puedes darla por sentada; debes construirla cada día. Esto aplica tanto a las personas como a las máquinas”.

El papel de las escuelas de negocios y los líderes del futuro

Mann también interpela a los educadores. Como profesor invitado en INSEAD y titular en HEC Paris y EDHEC Business School, sostiene que las escuelas de negocios deben reinventar cómo preparan a los líderes para un mundo donde el valor lo crean no solo humanos, sino también máquinas.

“Ya no podemos enseñar únicamente la maximización de ingresos y beneficios. El manual de reglas de los negocios debe cambiar”, insiste. “Tenemos que diseñar nuevas ecuaciones de prosperidad que integren valor social y humano. Si las escuelas no se toman esto en serio, estaremos perdiendo el rumbo de toda una generación”.

Tenemos que diseñar nuevas ecuaciones de prosperidad que integren valor social y humano. Si las escuelas no se toman esto en serio, estaremos perdiendo el rumbo de toda una generación

Para los profesionales jóvenes más ansiosos por construir carreras en la intersección entre tecnología, ética y negocio, su consejo es simple pero exigente: "alinea pasión con propósito, aprende sin descanso y cultiva la confianza como tu estrella polar".

La integridad como nueva ventaja competitiva

Hamilton Mann cree que estamos al comienzo de una revolución. Como en cambios industriales pasados, esta encierra una promesa inmensa pero también el potencial de tener consecuencias dramáticas. La verdadera prueba será si podemos insertar la integridad tan profundamente en la IA como antes incrustamos la seguridad en la aviación o la fiabilidad en las redes energéticas.

“La próxima frontera de la IA no está en desarrollar modelos cada vez más sofisticados o potentes. Está en incrustar la integridad en el núcleo del diseño de la IA". Se trata de asegurar que podamos diseñar sistemas de IA que actúen de maneras que sostengan la confianza, reflejen los valores de la sociedad y contribuyan de forma constructiva a las comunidades humanas porque, por diseño, son capaces de demostrar un comportamiento guiado por la integridad con la mayor fidelidad posible.

En ese sentido, la integridad artificial desplaza el foco del mero desempeño de tareas al imperativo de defender la integridad, no solo la inteligencia. Aboga por sistemas de IA que actúen correctamente con respecto a los derechos humanos universales, los valores compartidos, las normas sociales, los imperativos medioambientales y los matices culturales, mientras aprenden continuamente desde esta perspectiva”.

Si tenemos éxito, la IA no solo será ingeniosa, será digna de confianza. Y en esa confianza, Hamilton Mann ve la base tanto del progreso social como del éxito empresarial sostenible.